形状只是数字间几何图形的涌现。

在我们研究的模型中,一些神经元确实清晰地映射到特征。但特征与神经元的对应关系并不总是如此清晰,尤其是在大型语言模型中,神经元与清晰的特征对应起来实际上似乎很少见。

这带来了很多问题。为什么神经元有时与特征一致,有时却不一致?为什么有些模型和任务有许多这样的干净神经元,而在其他模型和任务中却很少见?

在本文中,我们使用玩具模型(在具有稀疏输入特征的合成数据上训练的小型 ReLU 网络)来研究模型如何以及何时表示比其维度更多的特征。我们称这种现象为叠加现象。当特征稀疏时,叠加可以实现超出线性模型所能进行的压缩,但代价是需要非线性滤波的“干扰”。

玩具模型观察到的叠加现象:

- 叠加是一种真实的、可观察到的现象。

- 单义和多义神经元都可以形成。

- 至少某些类型的计算可以通过叠加来执行。

- 特征是否以叠加方式存储由相变决定。

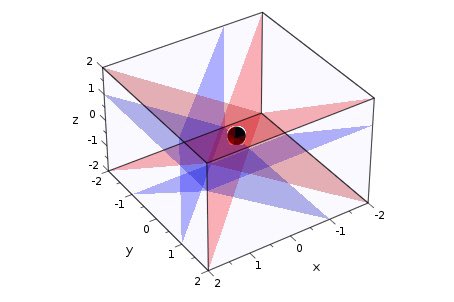

- 叠加将特征组织成几何结构, 例如二边形、三角形、五边形和四面体。

这个玩具模型是简单的 ReLU 网络,因此可以公平地说,神经网络至少在某些情况下表现出这些属性,但目前还不清楚如何将其推广到真实网络。