深度神经网络 (DNN) 至今人们还无法从理论层面解释其第一性原理,它们是模拟人类大脑神经元相互作用的一种类比产物,如何从类比思维产物过渡到第一性原理的解释,意味着实践推动理论的发展。以下是Facebook试图通过对深度神经网络第一性原理的解释尝试推动AI理论发展:

蒸汽机推动了工业革命并永远改变了制造业——然而直到接下来的一个世纪热力学定律和统计力学原理得到发展,科学家们才能够在理论层面上充分解释它为什么以及如何工作。

当然,缺乏理论理解并没有阻止人们改进蒸汽机,但是发现热机的原理导致了快速改进。当科学家们最终掌握统计力学时,其后果远远超出了建造更好、更高效的引擎。统计力学使人们认识到物质是由原子构成的,预示着量子力学的发展,并且(如果你从整体来看)甚至导致了为你今天使用的计算机供电的晶体管。

今天的人工智能也处于类似的关头。深度神经网络 (DNN) 是现代 AI 研究的重要组成部分,但它们或多或少被视为“黑匣子”。虽然人工智能从业者取得了实质性进展,但 DNN 通常被认为太复杂而无法从基本原理来理解。模型主要通过反复试验进行微调——虽然试错可以智能地完成,通常是根据多年的经验进行的,但它是在没有任何统一的理论语言来描述 DNN 及其功能的情况下进行的。

今天,我们宣布出版《深度学习理论原理:理解神经网络的有效理论方法》,这是 Facebook AI Research 的 Sho Yaida、麻省理工学院和 Salesforce 的 Dan Roberts 以及普林斯顿大学的 Boris Hanin 之间的合作。在基本层面上,本书提供了一个理论框架,用于从第一原理理解 DNN。对于 AI 从业者来说,这种理解可以显着减少训练这些 DNN 所需的试错量。例如,它可以揭示任何给定模型的最佳超参数,而无需经过当今所需的时间和计算密集型实验。

相互作用的神经元

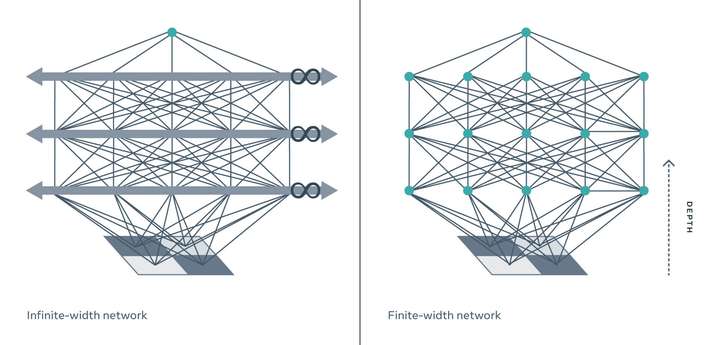

到目前为止,试图理解 DNN 的理论家通常依赖于对此类网络的理想化,即所谓的无限宽度限制,其中 DNN 以每层无限数量的神经元进行建模。

从物理学家的角度解决这个问题,深度学习理论的原则通过在有限宽度上提出有效的 DNN 理论,改进了这个无限宽度的限制。

传统上,物理学家的目标是创建最简单、最理想的模型,同时将描述现实世界所需的复杂性降至最低。在这里,这需要取消无限宽度的限制,并系统地整合所有需要考虑的有限宽度效应的修正。用物理学的语言来说,这意味着对一层和跨层神经元之间的微小相互作用进行建模。

想象两个台球向着对方前进。如果您使用类似于无限宽度限制的非交互模型来计算将要发生的事情,您会发现球会相互穿过并继续朝同一方向前进。但显然情况并非如此。球中的电子不能占据相同的空间,因此它们会相互作用碰撞弹跳。

这些相互作用在现实生活中很重要,在物理学中很重要,对 DNN 也很重要。(无限宽度导致神经元的相互作用可能性降低,只有有限宽度才提供神经元碰撞的上下文)

考虑到神经元之间的类似相互作用,该书的理论发现 DNN 的真正威力——它们从数据中学习世界表征的能力——与其纵横比(即深度与宽度之比)成正比。对于无限宽度模型,该比率为零,因此这些玩具模型无法捕捉深度,并且随着 DNN 深度的增加,它们的描述变得越来越不准确。相比之下,使用有限宽度层,有效理论实际上会影响深度——这对于表示学习和DNN的D真正重要的其他应用至关重要。

打开盒子

虽然书中描述的框架可以扩展到现代 AI 社区使用的现实世界 DNN,并提供了这样做的蓝图,但本书本身主要侧重于最简单的深度学习模型(深度多层感知器),目的是操作说明。

应用于这种最简单的架构,可以系统地求解有效理论的方程。这意味着我们可以对 DNN 在整个训练轨迹上的行为有第一性原理的理解。特别是,我们可以明确地写下经过充分训练的 DNN 正在计算的函数,以便对新的测试示例进行预测。