Stream数据流处理模式

在Golang中使用泛型实现slice排序 - gosamples

排序是新泛型功能的一个非常自然的用例。在Go中对slice进行排序是以前每次有新的slice类型时都要重新编写的事情之一。有时你会为两种不同的类型使用相同的代码。从Go 1.18开始,由于新的泛型功能.

在Golang中使用泛型实现slice过滤filter()函数 - gosamples

到目前为止,在 Go 中创建函数 filter() 是很困难的,它可以根据谓词的布尔值来过滤任何元素的列表。如果你知道列表的类型,这是有可能的。func filter(slice []string, .

使用Golang中的泛型创建“map”函数 - gosamples

map()函数是另一种函数式编程范式,由于新的泛型功能,它可以在Go中轻松实现。它的工作原理是应用一个函数,将单个slice元素作为参数,对其进行转换,并返回输出值,其中采取和返回的类型不一定相同。例.

在Golang中使用泛型reduce函数 - gosamples

reduce()函数是由 JavaScript 和 Python 等其他编程语言推广的函数式编程概念。它的工作原理是通过对数组中的每个元素应用一个产生部分结果的函数,将一个数组还原成一个单一的值。最后.

RangeBitmap提升Java流数据过滤性能

假设您正在使用 Java 进行某种数据分析,也许您正在分析交易(如销售)。Transaction在对对象执行计算之前,您需要评估复杂的过滤器。 public static final class T.

用Java optional模仿Kotlin? - Welsh

让我们先来看看Optional(在Java8中引入)是做什么的?Optional是对一个对象的封装,提供了安全处理底层对象的方法,同时避免了可怕的空指针异常。这提供了与Kotlin的nullable数.

Netflix万亿级实时数据基础设施的四个创新阶段

徐振中于201 年加入 Netflix,担任实时数据基础架构团队的创始工程师,后来领导了流处理引擎团队。他分享了他的团队的主要成就: 在 Netflix 的所有组织中将流数据用例从 0 增加到 200.

j-easy/easy-rules: Java简单的规则引擎

Easy Rules 是一个简单而强大的 Java 规则引擎,提供以下功能: 轻量级框架和易于学习的 API 基于 POJO 的开发 有用的抽象来定义业务规则并轻松应用它们 从原始规则创建复合规则的能.

SeaTunnel用于海量数据的同步和转换

SeaTunnel 是一个分布式、高性能的数据集成平台,用于海量数据(离线和实时)的同步和转换。SeaTunnel 原名 Waterdrop,2021 年 10 月 12 日起更名为 SeaTunne.

在Java中用规则引擎模式替代ifelse - Vitali

规则引擎模式:这种模式的本质是if - else ,拆分if - else每个分支到规则类中,然后,主规则引擎类将保存所有规则并找到与客户端请求匹配的规则。定义规则类为了确保所有规则类都实现相同的方法.

事件流平台Kafka、Pulsar和RabbitMQ比较 - Picnic

让我们首先将事件定义为机器可读数据,当发生某些事情时,设备或服务会发出该数据,例如,客户在应用程序中单击。事件流是单个事件或小批量事件从生产者到消费者的代理和传输过程。事件流平台正在接收、即时转换事件.

MicroStream + Helidon高性能Java持久层

MicroStream是行业中真正的游戏规则改变者。如果你想创建真正高性能的微服务,在真正高压的环境中工作,那么Helidon + MicroStream是一个非常好的选择!它不仅易于设置和使用,而且.

如何在Java中使用Deque? - Java67

Queue 和 Deque的区别在于 ,您只能从 Queue 的后端添加元素,但可以在 Deque 的前端和后端添加元素。考虑你想实现一个售票柜台。人们可以从最后进入队列,并将从前面移除。而且,为了实.

反应性和非反应性代码的分离 - DZone

避免在使用 Project Reactor 时因混合反应性和非反应性逻辑而导致的意外行为。在使用 Project Reactor 或任何其他反应式流实现时要记住的最重要区别之一是代码执行中组装asse.

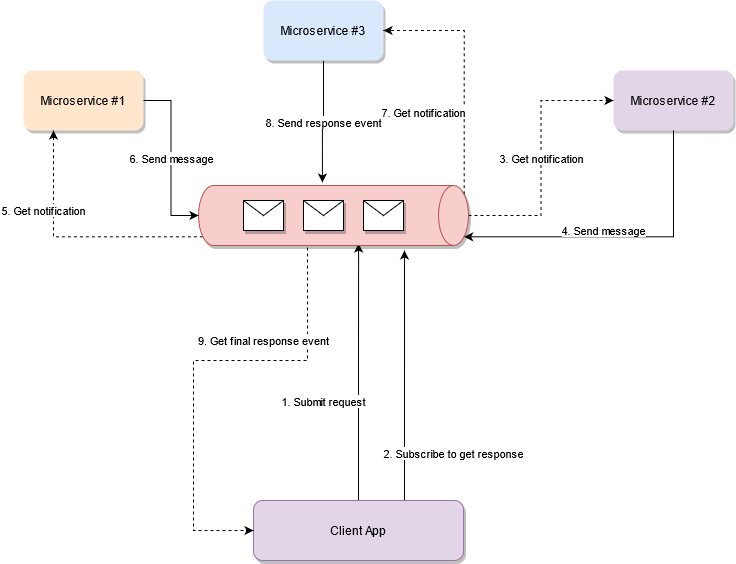

基于Redis构建微服务的反应式架构 - bitsrc

幽默:可组合性是软件的复利

可组合性之于软件,正如复利之于金融。 软件的可组合性需要更深思熟虑的思考,并且更难像复利那样简单地实施。可组合性(相对于复利)的优势在于新手不必从头开始。这绝对是我认为导致软件驱动经济呈指数增长的原.

Python中的Map、Reduce和Filter函数式编程

构成函数式编程范式核心的三个关键函数是 Map、Filter 和 Reduce。 Map在 map 函数中,您作为参数传递的函数将应用于可迭代对象。如果您熟悉列表推导式,Map 函数也有类似的效果。当.

将if-else之类嵌套循环重构为函数式管道 - XP123

嵌套结构难以阅读;管道stream通常更容易阅读和思考。嵌套结构具有“厄运之箭”的感觉,您需要同时管理所有父结构的上下文;而管道stream通常是线性的。 许多语言都添加了“函数式管道”风格,建立在首.

Java Stream过滤器案例解说 - Foojay

使用 Java 流操作集合中的数据比其他方法更方便、更简洁。import java.util.stream.IntStream;public class LimitStreamChallenger {.

大数据处理与数据工程Lambda架构简介

我们生活在一个技术时代,大数据、物联网、机器学习都已成为不可避免的现实。在当今世界,决策过程依赖于可以跨越各种数据源(例如社交媒体、日志文件、传感器数据等)的数据。虽然数据的异构性增加了多方面,但随之.

Javascript的map、reduce、filter新数组使用方法

数组是编程世界中最常用的数据结构。较新的数组方法,如map(),reduce()和filter()广泛用于使用一些库/框架(如 React/Vue/Angular)构建项目。在这篇博文中,我将通过真实.

推特大规模应用的流处理框架:Apache Heron

Apache Heron是实时、分布式、容错的流处理引擎。自 2014 年以来,Heron 为 Twitter 的各种用例提供了所有实时分析的支持。事件报告下降了一个数量级,证明了经过验证的可靠性.

RabbitMQ推出类似Kafka的流Stream

RabbitMQ 3.9 引入了一种新型数据结构:流。Streams 解锁了一组用例,使用“传统”队列实现这些用例可能很乏味。让我们在这篇文章中发现流如何扩展 RabbitMQ 的功能。RabbitM.

Java 9 中的ofNullable方法 | foojay

从 Java 9 开始,当我们需要操作 List 中的值时,可以将 Optional 与流一起使用。在本次 Java 挑战赛中,我们将探索在 Optional! 中使用流的方法!如下执行main方法后.

高效实现大数据流式处理大型API响应的注意事项 - simonwillison

过去,大多数 Web 工程师会很快否定 API 端点的想法,即流式输出无限数量的行,他们认为应尽快处理 HTTP 请求!处理请求所花费的时间超过几秒钟都是一个危险信号,现在应该重新考虑某些事情。Web.

Java 8 StringJoiner字符串连接器

在这篇简短的文章中,我们将介绍Java 8 StringJoiner特性,并将探索有哪些不同的特性以及如何更有效地使用Java 8 Stream API。在日常编程活动中的一项非常常见的任务中加入多个.

如何迭代Java枚举?

Java Enum是一种特殊的数据类型,它提供了一个特性来定义一组预定义的常量。在这篇文章中,我们将讨论迭代 Java Enum 的不同方法 。枚举可以包含常量、方法等。public enum Day.

Java函数式编程中归约reduce()的使用教程

归约Reduce流运算允许我们通过对序列中的元素重复应用合并操作,从而从元素序列中产生一个单一结果。其中参与者有三者: 标识identity:代表一个元素,它是归约reduce运算的初始值,如果流为空.

幽默图:升级到Java 8使用函数式编程以后

Java中Stream的teeing()方法用于处理合并两个Collector - foojay

什么是teeing()方法?返回一个由两个下游collectors组成的Collector。传递到结果collectors中的每个元素都是由两个下游collectors处理的,然后使用指定的合并mer.