大语言模型LLM

Petals:在家中就能运行P2P大语言模型

Petals是一个社区运行的系统:相互依靠人们共享他们的GPU。Petals 以协作方式运行 Llama 和 BLOOM 等大型语言模型--您只需加载模型的一小部分,然后与提供其他部分服务的人员一起运.

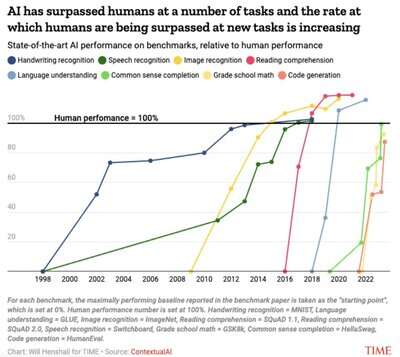

AI基准测试已经接近或超越人类

代号为Gobi的GPT-5即将发布

据报道,OpenAI 正在加紧努力发布一种名为 GPT-Vision 的先进多模式法学硕士,代号为Gobi。随着秋天的临近,谷歌和OpenAI陷入了一场传统的软件竞赛,旨在推出下一代大型语言模型:多模.

Apple 全新 Transformer 支持的预测文本模型

在今年早些时候的 WWDC 上,苹果宣布即将推出的 iOS 和 macOS 版本将配备一项由“ Transformer 语言模型”提供支持的新功能,该功能将为用户“在打字时提供内嵌的预测文本建议”。这.

ChatGPT大语言模型只是句子补全?

如果你知道什么是马尔可夫链,就很容易把大语言模型想象成一个非常大的马尔可夫链,如果你知道,就把它等同于”句子补全“。想象一下,你让一台计算机阅读世界上的每一本书,然后让它为书中的每一个三字短语构建一个.

哈特奖:压缩算法竞赛奖

Hutter 奖是一项奖励智能压缩器/数据压缩程序开发的竞赛,目前总奖金为 23,034 欧元。目标是将 1GB 文件 enwik9 压缩到小于当前记录的约 114MB。根据所达到的压缩程度,获胜者有.

大型科学语言模型:关于 P 与 NP 的研究

使用大型语言模型(LLMs)来增强和加速对 P vs NP 问题的研究,这是理论计算机科学和数学领域最重要的开放性问题之一。具体来说,我们提出了苏格拉底式推理(Socratic reasoning)这.

Transformers中原生支持的量化方案概述

概述 Transformer 支持的每种量化方案的优缺点,以帮助您决定应该选择哪一种。目前,量化模型主要用于两个目的: 在较小的设备上运行大型模型的推理 在量化模型之上微调适配器 到目前为止,已经做出.

使用 ROScribe 自动创建 ROS 项目

ROScribe 是一个开源工具,它使用 GPT 询问您的机器人项目并为您创建 Python 中的 ROS 包。将自然语言翻译成机器人软件。ROScribe 使用自然语言界面来描述机器人项目,消除了初.

网友讨论Stephen Wolfram(斯蒂芬·沃尔夫勒姆)

腾讯使用大语言模型增强基于Doris的OLAP服务

腾讯利用大型语言模型 (LLM) 增强基于 Apache Doris 的 OLAP 服务腾讯采用大型语言模型 (LLM) 来增强其基于 Apache Doris 的 OLAP 服务。LLM作为将自然语.

大语言模型是在玩文字游戏?还是有人类意向性?

该文作者探讨了语言模型 (LLM) 可能在多个层面上具有意向性和代理的观点,质疑”机器人只是在玩聊天游戏“这样一个简单观点。通过下棋LLM的例子,作者认为LLM可以归因于言外意向性。作者认为,虽然LL.

人类如何区分幻觉与现实?

1910年,心理学家玛丽·切维斯的一项研究发现,当我们对某事物的感知与我们所想象的相匹配时,我们就会认为它是想象的。这在心理学中被称为“自信效应”。观察结果表明,我们脑海中的图像和世界上真实感知的图像.

大语言模型注定会产生幻觉?

像 ChatGPT 这样的所有主要人工智能语言模型都会产生幻觉,编造虚假事实。虽然无法解决,但整理训练数据和强化学习等步骤可以缓解这一问题。(来源)产生幻觉的原因是什么 模型仅根据统计模式及其训练数据.

幽默:百度文心有人情味还是幻觉?