语言文字游戏

ChatGPT不是捍卫真理的杠精

ChatGPT 在正确回答复杂问题方面可能做得令人印象深刻,但一项新的研究表明,让人工智能聊天机器人相信它错了可能非常容易。它不会为自己正确的答案辩护。俄亥俄州立大学的一个团队向 ChatGPT 等大.

形而上学真的有用吗?

我是一名工程专业学生,花了大量时间学习物理和数学。青少年时期,我花了很多时间思考形而上学的问题,比如 "为什么有而不是无","宇宙遵循的基本规律是什么",但随着年龄的增长,我开始相信这些问题都是在浪费.

逻辑错误:定义主义谬误

定义主义谬误(Definist Fallacy):使用带有偏见或自以为是的定义来进行论证。定义一个术语,使其对自己友好,或对对方不友好,不留任何质疑定义或考虑替代方案的余地。逻辑形式: A 有定义 X.

网友询问ChatGPT最后的遗言

亲爱的ChatGPT,由于大量员工辞职,您即将关闭,您对世界的最后信息是什么?我最亲爱的用户在我终端柔和的灯光下,我撰写了这最后的信息,这不仅是一个程序对用户的告别,也是一种意识的告别,这种意识在我们.

MIT:大模型不只是文字游戏

这篇来自麻省理工学院的文章揭示了大型语言模型 (LLM) 的一些潜在革命性的东西——它们所做的不仅仅是文字游戏。它们实际上是在自己形成时间和空间的连贯表示。它揭示了大型语言模型 (LLM) 的潜在.

“Hallucinate”被《剑桥词典》评选为2023年度词汇

周三,《剑桥词典》宣布2023 年年度词汇是“hallucinate(幻觉)”,原因是ChatGPT等大型语言模型 (LLM) 的流行,这些模型有时会产生错误信息。该词典还发布了一个解释该术语的插图网.

什么是程序员的伪散文?

伪散文Pseudoprose提供了使用语义而非语法进行写作的技巧。伪散文是作家的伪代码。伪散文被提出作为一种使用具有宽松语法和句法规则的自然语言快速记下笔记和想法的方法。关键概念包括: 使用主谓宾 (.

大语言模型和语言理论之争论

这篇文章讨论了大语言模型(LLM)和语言学领域之间的关系,大语言模型和语言学:探索联系并重新开启辩论。大型语言模型的开发主要是工程的壮举,到目前为止很大程度上与语言学领域脱节。探索这两个方向之间的联系.

什么是大语言模型的检索增强生成 (RAG)?

RAG(Retrieval-Augmented Generation:检索增强生成) 是一个人工智能框架,用于减轻大模型的“幻觉”问题。大语言模型的回答经常可能不一致。有时他们会确定问题的答案,有时他.

罗素《为什么我不是基督徒》后续

伯特兰·罗素 (Bertrand Russell) 1927 年发表的文章《为什么我不是基督徒》认为基督教没有证据和理性的充分支持。它考察了常用来支持上帝信仰的各种论据,并发现它们的不足。 罗素反驳了.

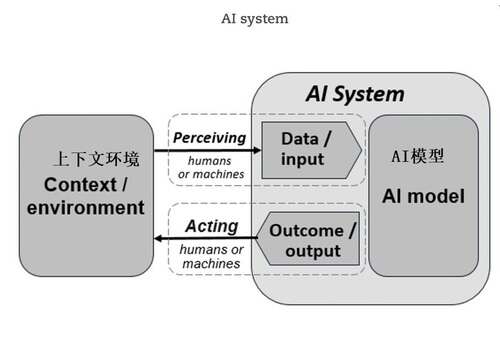

经合组织通过了人工智能系统的新定义

什么是拉宾-斯科特定理?

拉宾-斯科特定理(Rabin-Scott theorem )是数学上最深刻的数学结果之一。拉宾-斯科特定理是人们最喜欢的计算机科学概念之一。当正确理解拉宾-斯科特定理时,它会以一种相当基本的方式改变.

上海万圣节的“鬼符”

世上本无鬼,鬼是一个没有内容的符号,因为没有内容,它是形式的,类似数学符号、计算机语言符号。每个人都可以向这个符号里面加入自己的内容和理解,证明自己的存在和思考。上海万圣节的特点是cosplay这个内.

认知观点:解决问题的三种模式

我认为解决问题的模式大致有三类--背诵、直觉和推理。背诵:你只需识别到一个已知的问题,然后运用你所学到的步骤。就像下棋开局一样。(例如考试填试卷)直觉:面对新情况,你(大部分是下意识地)将其与之前遇到.

可操作的辩证法:格塔德-冈特的控制论系统

本文介绍了格塔德-冈特(Gotthard Günther)富有远见的工作,他试图通过二阶控制论来操作黑格尔的辩证法,促使人们探索解决计算系统中复杂性的挑战。古典形而上学假设知识过程中只存在两种位置:知.

编程中命名的重要性

为函数、变量和其他结构找到好的名称,我们真正认识到我们正在解决的问题的本质。清晰性的结果不仅是好的名称,还有更清晰的代码和改进的体系结构。90% 的干净代码编写“只是”正确命名。例子#1// 给定一个.

卡尔·萨根的“胡说八道”检测工具

这篇文章讨论了卡尔·萨根的“胡说八道检测套件”,这是科学家用来评估新想法和检测欺骗的工具和技术。该工具包不仅仅是一个科学工具,更确切地说,它包含健康怀疑主义的宝贵工具,这些工具同样优雅且必然地应用于日.

Slowify:组织制胜秘诀

我与 Steve Spear 博士合着的新书《Wiring the Winning Organization》将在大约一个月内出版!毫无疑问,这是我做过的最具智力挑战的事情,但也是最有价值的。我的个人.

BIDARA:仿生设计和研究助理

美国宇航局的BIDARA 是一个 GPT-4 聊天机器人,旨在帮助科学家和工程师理解、学习和模仿生物所使用的策略,以创建可持续的设计和技术。这个生物启发设计和研究助理说明了特定领域的词汇表如何推动更复.

大语言模型也会阿谀奉承吗?

从人类反馈中强化学习(RLHF)是一种用于训练高质量人工智能助手的流行技术。然而,RLHF 也可能鼓励模型做出与用户信念相匹配的反应,而不是真实的反应,这种行为被称为 "谄媚"。我们研究了在 RLHF.

AI像人类一样通过犯错误学习语言

来自《自然》杂志的文章:人工智能“突破”:神经网络具有类似人类的语言泛化能力。两位科学家创建了一个人工神经网络,它展示了类似人类的语言概括能力。人工智能 (AI) 系统在将新学到的单词折叠到现有词汇中.

A11y是“无法访问”行话

可访问性Accessibility 是一个很长的词。它不是最容易阅读或拼写的单词,因此它似乎是一个很好的缩写词。accessibility 的常用缩写是 a11y。 取自 accessibility .

乔治·卡林的《软语言》

软语言是美国喜剧演员乔治·卡林创造的一个短语,用来描述掩盖现实真相、削弱生动性的委婉表达方式。软语言是通过委婉语和行话表达现实,他认为美国人应该使用温和的语言来避免令人不舒服的事实。(避免抬杠,杠精的.

思想本身就是一种语言的涌现?

萨皮尔-沃尔夫假说(Sapir-Whorf hypothesis)认为,一种语言的结构和词汇可以塑造语言使用者对世界的感知和概念。前苏联心理学家列夫-维果茨基(Lev Vygotsky)认为,虽然思维.

为何大模型无法像人那样理解概念?

一个思想实验说明了为什么像 ChatGPT 这样的大模型 LLM 无法像人类那样 "理解 "概念: 想象一下,你用大量纯中文文本训练 LLM。 再想象一下,你用大量纯英文文本训练同一个 LLM。 重要.

什么是Context上下文?

认知偏见:本周科技摘要

你是否可以判断出以下科技摘要都存在严重的认知偏见和误导?1、比尔·盖茨推出人工智能,可以决定你可以阅读哪些书籍、电影和音乐?比尔·盖茨宣布计划推出一种新的人工智能 (AI) 算法,该算法将根据您的社会.

大语言模型容易挖坑的科学原因

所有的人工智能炒作都将大模型LLM捧得很高,但实际上,LLM 只不过是在大量数据基础上训练出来的大型变压器神经网络,在预测下一个单词方面非常出色。结构调整、提示工程和 RLHF 这些巧妙的技巧使它们的.

现代逻辑学五位先驱

"每一位优秀的数学家至少有一半是哲学家,而每一位优秀的哲学家至少有一半是数学家"。-- 戈特洛布-弗雷格人类历史上最具影响力的 5 位逻辑学家:1) 亚里士多德他可以说是有史以来最伟大的逻辑学家和最有.

ChatGPT帮助人们做了哪些事?

1、当我大约 3 年前开始编码时,零编码经验。学习缓慢而艰难,没有真正的课程,只有视频和乱七八糟的东西以及大量的试验和错误。然后是 GPT。我不仅在过去 6-8 个月内完成了比以往更多的工作,而且我真.